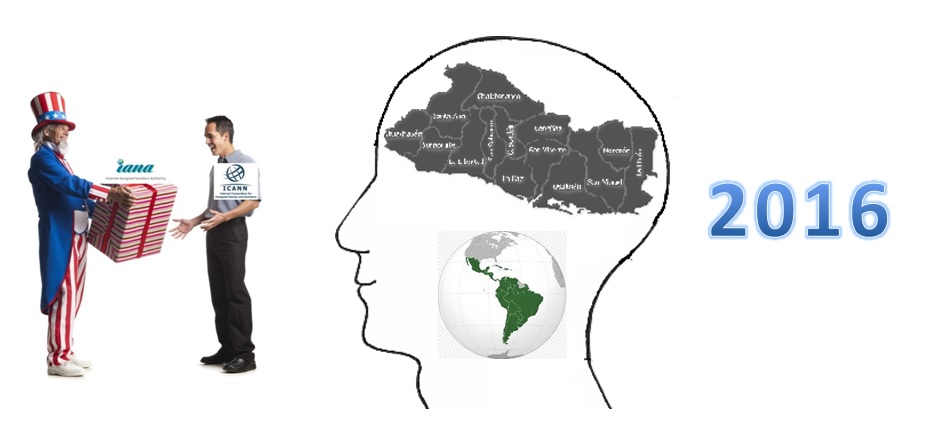

Un reciente estudio realizado por Internet.org, la organización auspiciada por Facebook, presenta un índice compuesto por cuatro aspectos, que evalúa para el 2016, el nivel de inclusión que muestra Internet en 75 países. Nuestro país, El Salvador, se encuentra en la posición 40 de inclusión, de acuerdo a este indicador.

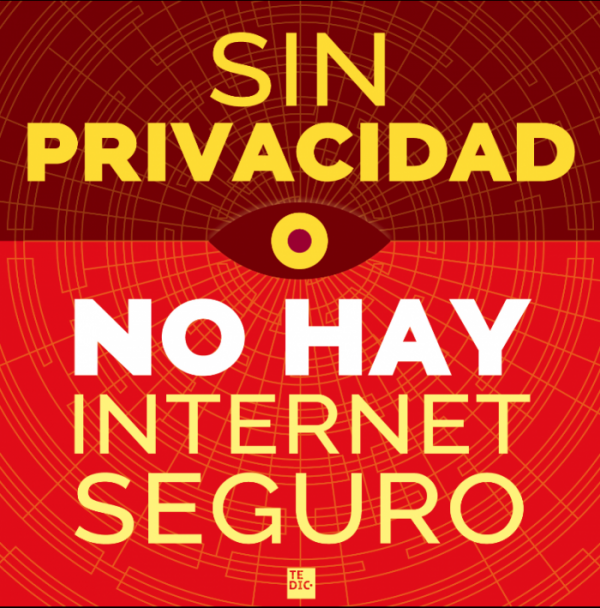

Una de las premisas que orientan el desarrollo de esta investigación se halla en su sitio web: “Para que las personas se beneficien de Internet, no sólo debe estar disponible y asequible. También debe ser relevante para sus vidas y deben tener las habilidades y la confianza para usarlo. Este índice evalúa hasta qué punto 75 países están logrando estos pilares de inclusión”.

Otras justificaciones y bases para el estudio son:

Otras justificaciones y bases para el estudio son:

- “No hay inclusión sin infraestructura. ¿Qué tan buenos son los países en cuanto a uso, calidad, infraestructura y electricidad?”

- “Una Internet inclusiva debe ser asequible para todos. Vea cuáles son los países que ocupan los primeros puestos en el ranking de precios y el entorno competitivo”.

- “Para que Internet aporte valor a la vida de las personas debe contener contenido relevante y en un lenguaje que puedan entender. Así es como los países se acumulan en relevancia”.

- “La cultura y la política impactan en la Inclusión en Internet. Averigüe cómo clasifican los países en la alfabetización, igualdad de acceso para las mujeres y otras medidas de preparación”.

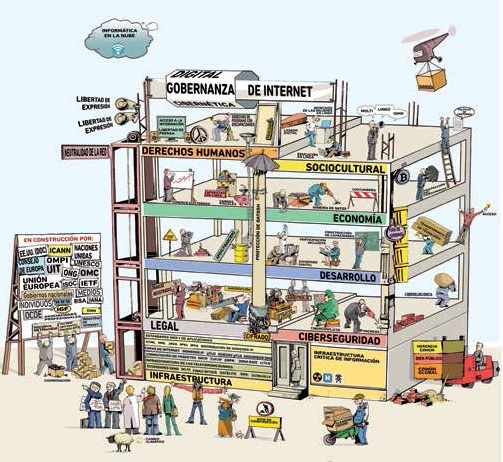

Los componentes del índice

El sitio web define los componentes del índice, así como los elementos que pueden ser considerados en cada uno de ellos.

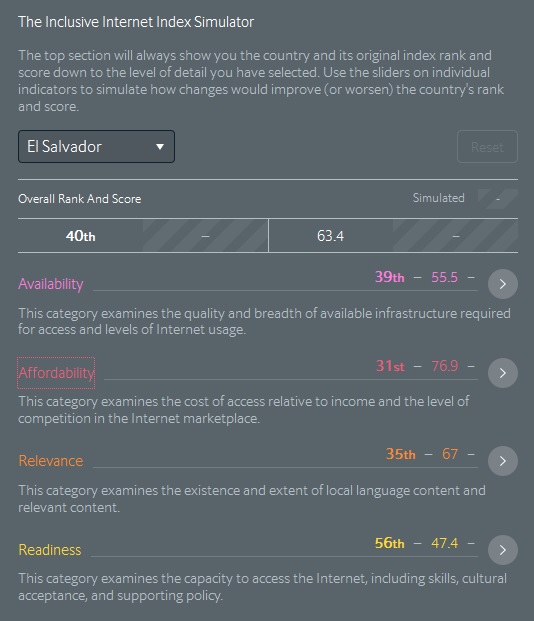

Los países se clasifican en general y en cuatro categorías: Disponibilidad, Asequibilidad, Pertinencia y Preparación. Los puntos representan las puntuaciones transformadas (escala: 0-100 donde 100 = mejor).

- Disponibilidad: Esta categoría examina la calidad y amplitud de la infraestructura disponible necesaria para el acceso y los niveles de uso de Internet.

- Asequibilidad: Esta categoría examina el costo de acceso en relación con los ingresos y el nivel de competencia en el mercado de Internet.

- Pertinencia: Esta categoría examina la existencia y el alcance del contenido del idioma local y del contenido relevante.

- Preparación: Esta categoría examina la capacidad de acceso a Internet, incluyendo habilidades, aceptación cultural y políticas de apoyo.

Algunos de los hallazgos más relevantes del estudio son:

- Hay más para la inclusión que la disponibilidad de Internet

- Los países de ingresos medios superan a los ricos en algunas áreas de la inclusión

- El contenido local es abundante en los países que no hablan inglés

- Nepal, Tanzania y Senegal son los países de bajos ingresos con mejor desempeño para permitir la inclusión en Internet

- Taiwán, España y el Reino Unido lideran el mundo para asegurar que las mujeres se puedan conectar a internet

- Los puntos de intercambio de tráfico de Internet (IXP) pueden permitir el crecimiento del contenido local, pero no en forma aislada

El índice para El Salvador

Como en otros indicadores comparativos, mientras mayor sea el puntaje obtenido en cada categoría o componente, mejor posición se obtiene en el ranking ordenado.

Entonces, nuestro país, El Salvador, se ubica en esta versión 2016 del índice, en las siguientes posiciones:

General: Posición 40, puntaje 65.4

Disponibilidad: Posición 39, puntaje 55.5

Asequibilidad: Posición 31, puntaje 76.9

Pertinencia: Posición 35, puntaje 67.0

Preparación: Posición 56, puntaje 47.4

De un total de 75 países que fueron incluidos en esta edición, pareciera que las posiciones menores a la mitad son buenas noticias. Aunque eso no es así necesariamente, nuestro país sólo obtuvo una de esas posiciones, en Asequibilidad. Está claro que aún falta mucho por hacer.

En nuestros países se hace más evidente una de las conclusiones del mismo estudio, refiriéndose a Latinoamérica:

“Por supuesto, el desarrollo de la estrategia es sólo la mitad de la batalla. La implementación de las estrategias, aunque son bien pensadas, se retrasa demasiado en países en desarrollo, según varios expertos entrevistados para este estudio. Antonio García Zaballos, especialista principal en telecomunicaciones en el Banco Interamericano de Desarrollo, sostiene que «en América Latina, la implementación de los planes nacionales de TIC es demasiado a menudo una reflexión y acción tardías. Los gobiernos necesitan hacer más que elaborar planes nacionales de conectividad; también deben implementarlos».