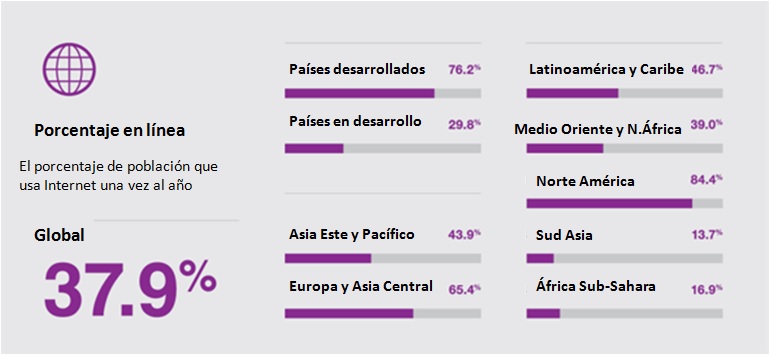

La aseveración que da título a esta entrada puede sonar bastante ruda, desafiante y controversial. Incluso puede ser considerada una falacia, inventada por esa gran cantidad de innovadores y personas de negocios que utilizan Internet como su principal vehículo para comercializar sus productos y servicios.

Sin embargo, para un creciente número de personas, sobre todo los jóvenes integrantes de la generación de nativos digitales, la generación Y, la frase no se aleja mucho de su vida normal y diaria. Para la generación Z, los que vienen después y que en la actualidad son aun niños y adolescentes, ser parte de la gran red seguramente será considerado un elemento esencial definitorio de su identidad.

La presencia en Internet se refiere tanto a la vida personal como a la profesional. Hace ya algunos años que en las tarjetas de presentación y como medio de comunicación se incluye y se utiliza una dirección de correo electrónico, aunque sea dentro de uno de los muchos servicios gratuitos de correo electrónico. Esta presencia también se refiere a las cuentas que se abren en las redes sociales, que son usadas tanto para aspectos personales como para actividades laborales.

Ya sea como parte de un conglomerado genérico en las redes sociales o espacios de publicación libres o, mejor aún, con identidad propia e individual por medio de nombres de dominio seleccionados por nosotros mismos, el mundo camina a grandes pasos hacia la administración y cuidado de nuestras relaciones personales, comerciales y laborales en el inmenso foro que es Internet.

Nombres propios versus hospedajes genéricos

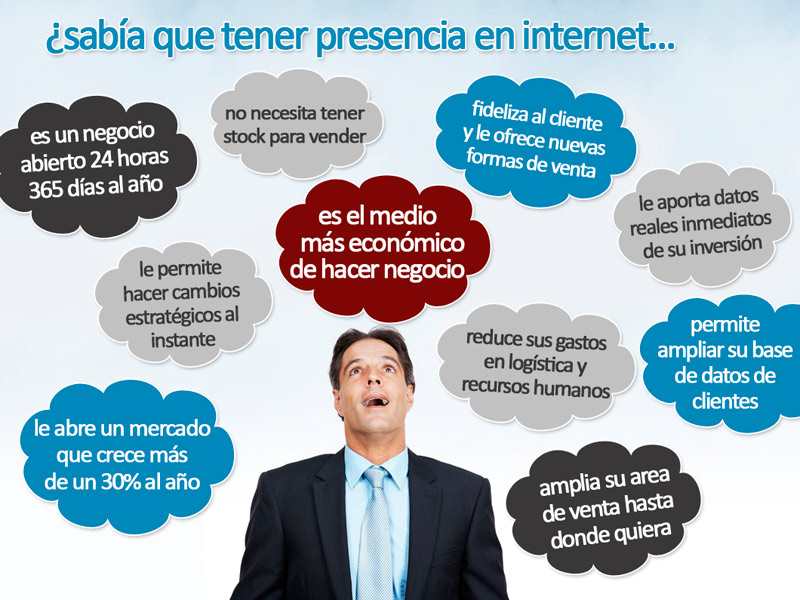

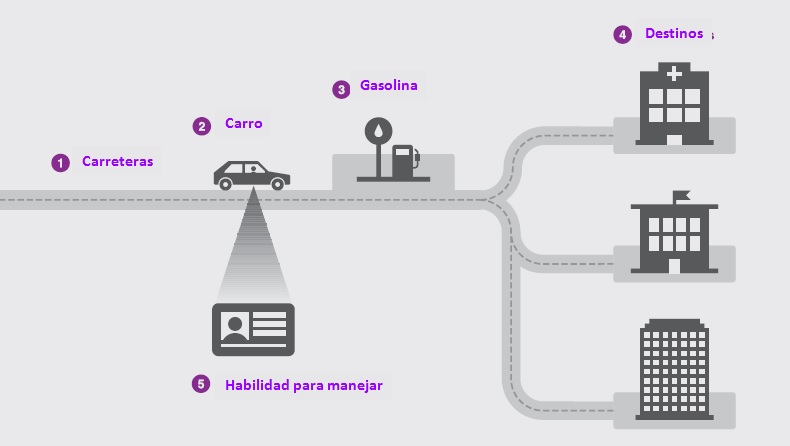

Al considerar crear y mantener presencia en Internet, sobre todo con objetivos comerciales, profesionales o sociales, un aspecto de gran relevancia que debe ser considerado es la dirección o referencia con la que se invitará a clientes y usuarios a conocer nuestras actividades.

Una disyuntiva que se presenta en ese sentido es la decisión de contar con un nombre de dominio propio o ser parte de otros sitios genéricos, algunos de ellos en forma gratuita. Si bien parece lógico pensar que, así como la marca y nombre de modelo que se usan comercialmente para denominar instituciones, proyectos, iniciativas, productos o servicios, también sea importante registrar los nombres propios y sus derivados como nombres de dominio en Internet.

La alternativa es usar sitios genéricos, incluyendo algunas de las llamadas redes sociales, en los que se puede colocar alguna presencia de marcas, modelos y demás distintivos comerciales y sociales. Usualmente se considera que esta posibilidad representa un menor costo e inversión, puesto que se toman en cuenta solamente los costos de entrada, y no se incluye la sostenibilidad y mantenimiento.

Por el otro lado, registrar uno o varios nombres propios como nombres de dominio permite diseñar y publicar un sitio web administrado por la misma entidad que lo genera, ya sea con personal propio o por medio de la contratación de empresas dedicadas a esta tarea. También permite crear una cantidad ilimitada de cuentas de correo electrónica, y transmitir a los clientes, usuarios, proveedores y aliados, presentes y potenciales, la apropiación de una identidad única en el vasto ciberespacio y el concierto mundial.

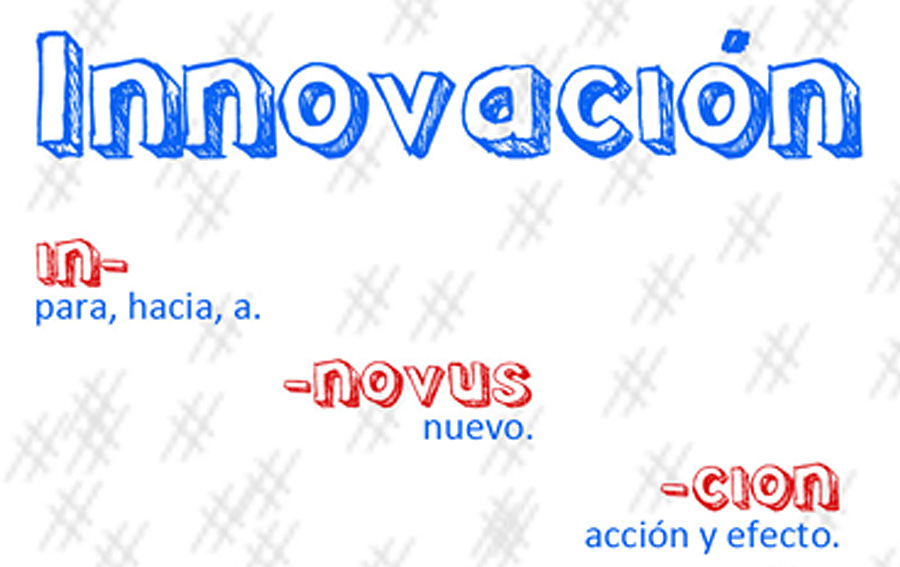

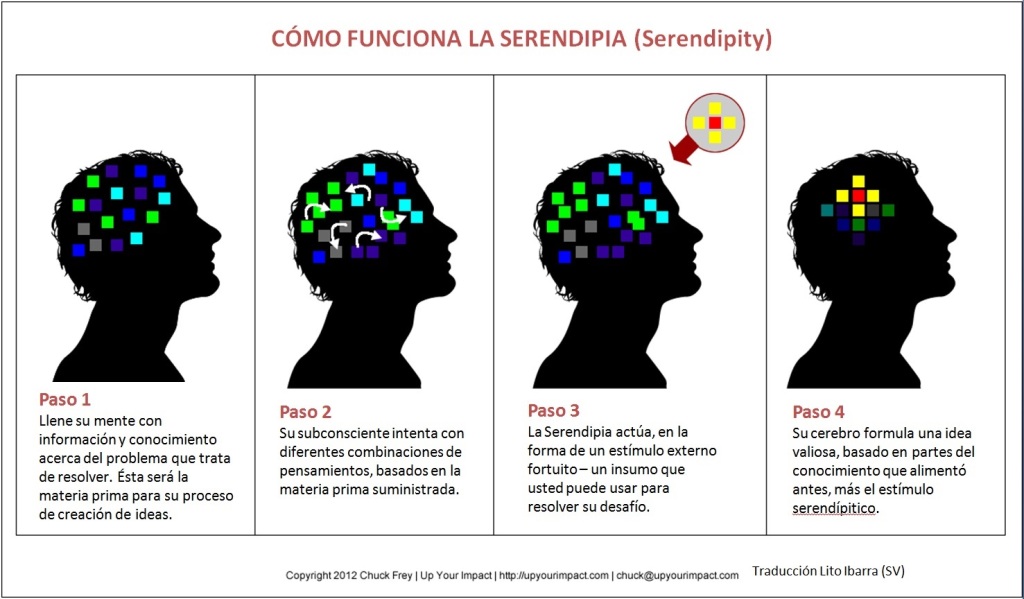

La posibilidad de variantes creativas

El registro de nombres de dominio es muy diferente al régimen de marcas registradas, ya que son de naturaleza y origen distintos. Además de los procesos de registro, la ausencia de categorías, las políticas propias, el alcance nacional o mundial, y otros elementos, cualquier persona o entidad puede registrar un dominio que sea no solamente una marca o un nombre, sino hasta frases, lemas, slogans, campañas y otras variantes creativas.

Por ejemplo, se puede registrar nombres de dominio como “mimarcaeslamejor.com.sv”, “segunda-prenda-a-mitad.com.sv”, “votepormi.sv”, “juanperez2015.sv” y otros parecidos, que probablemente tengan vigencia temporal, y claramente no son marcas ni nombres de instituciones, pero pertenecen y son utilizados por las organizaciones que las auspician.

Estas formas de uso de los nombres de dominio es válida para la mayoría de nombres de dominio de nivel superior, tanto genéricos como códigos de país. En muchos casos también se pueden registrar nombres y/o apellidos de personas naturales, lo que es muy ventajoso para las llamadas profesiones liberales, tales como abogados, consultores, médicos, etc.

Asociado a la presencia en Internet, ya sea por medio de nombres de dominio o en las redes sociales, se encuentra el tema de la reputación digital, entendido como las referencias a las menciones, sitio web, dirección de correo, escritos y publicaciones generadas por una persona o una institución, pública o privada. Obviamente, todos deseamos que nuestra reputación sea buena y se mantenga en forma positiva, tanto en la vida presencial como en nuestra vida en el ciberespacio.

Si bien es exagerado decir que si no tenemos presencia en Internet no existimos, en el mundo actual la afirmación no deja de tener cierta base importante. Suficiente para dedicarle un tiempo para su reflexión.