Estamos estrenando un nuevo año, recién salido de la fuente que produce en forma continua e interminable el paso del tiempo. Obtenemos doce meses sin usar cada inicio de año, y algunos de los eventos en esos días por venir dependen total o parcialmente de lo que hagamos, y sobre todo, de con qué actitud veamos el futuro.

Tanto a nivel personal como en el conglomerado de cada país y, en última instancia, de la humanidad, el avance o retroceso que experimentamos con el paso del tiempo se debe a lo que, colectivamente, hacemos a favor o en contra de nuestra propia raza y las demás especies que nos acompañan en este planeta.

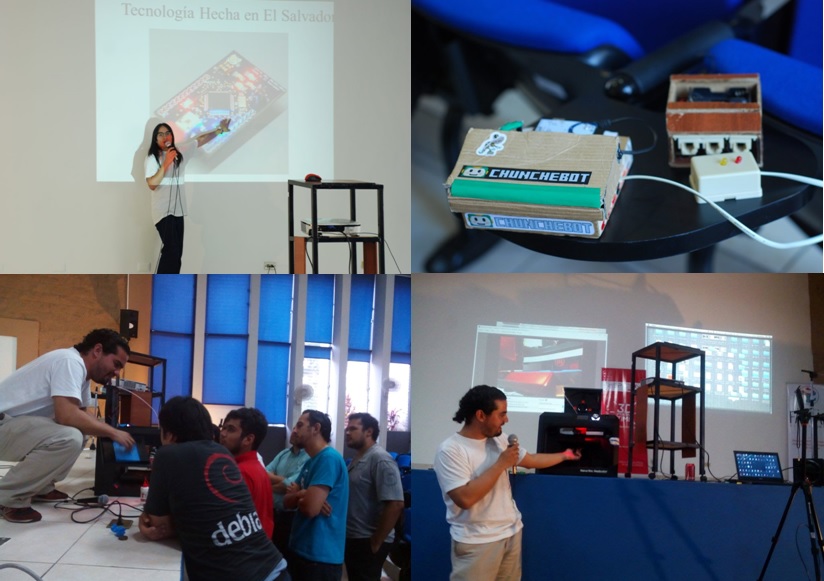

En materia de ciencia y tecnología, sin duda la humanidad seguirá desarrollando cada vez más dispositivos, principios y métodos para hacer más fáciles nuestras tareas, o mejorar nuestro nivel de vida, o para realizar acciones de dudosa calificación o incluso dañinas para nosotros mismos, como seres humanos.

La relación de la tecnología con nosotros, los humanos, será siempre un motivo constante de análisis y reflexión, buscando encontrar siempre la justa medida entre la dependencia absoluta de los apoyos y soportes basados en la tecnología y la no utilización de la misma. Este tema es más fácil de visualizar y considerar al pensar en el uso que hacemos del teléfono móvil, las tablets, laptops y computadoras de escritorio, y el nivel de dependencia que tenemos de las mismas.

Una visión anticipada

En 1909, cuarenta años antes de que George Orwell publicara su famosa novela “1984”, de la que surgen conceptos utilizados recientemente, como el del Gran Hermano, que vigila y sabe absolutamente todo sobre nosotros mismos, Edward Morgan Forster, novelista inglés, autor de “Un pasaje a la India” y “Un cuarto con una vista”, escribió un breve cuento de ciencia ficción llamado “La Máquina se detiene” (“The Machine stops”).

Tan temprano como a principios del siglo XX, incluso antes de la primera guerra mundial y tantos desarrollos, positivos y negativos, que nos dejó dicha centuria, Forster visualizó un futuro para la humanidad que nos advertía desde ese entonces acerca de los riesgos que conlleva una dependencia extrema de la tecnología.

El relato nos presenta una humanidad que vivía bajo la tierra, y que no necesitaba realizar ningún esfuerzo, pues la Máquina, así, escrito con mayúscula, es la entidad que se encarga de todas nuestras necesidades humanas, tanto fisiológicas como espirituales y de comunicación.

Los personajes centrales, madre e hijo, viven separados por muchos kilómetros, y normalmente no necesitan ni quieren verse, pues cuentan con las pantallas y medios de comunicación, que en el presente llamamos digitales, para mantener su relación.

Una advertencia clara

Como sería de esperar, la narración nos conduce hacia una “anormalidad”, cuando el hijo, Kuno, desobedece las reglas habituales, y salvando algunos obstáculos, se asoma a la superficie del planeta, y descubre a algunos disidentes, sembrando la duda en él, que a su vez lo comenta con su madre, una convencida de las bondades de vivir bajo la protección y cuidado de la casi divina Máquina.

El problema se da cuando la Máquina, misteriosamente, deja de realizar sus funciones de soporte y apoyo a todos los seres humanos de la tierra. La dependencia excesiva y total por parte de los avanzados habitantes del subsuelo terrícola de la tecnología que la Máquina representa y provee, se vuelve en su contra cuando ésta se detiene.

El corto libro, de fácil lectura, nos advierte, de una forma suave pero firme, que debemos mantener un poco de independencia de la tecnología que nos rodea, sin que eso nos convierta en enemigos de la misma.

A la par de los propósitos para adelgazar, ser mejor persona, estudiar más y realizar esas actividades que tanto hemos postergado, podemos incluir en la lista de año nuevo revisar nuestra relación con la tecnología y, cuando menos, comunicarnos con nuestros seres queridos en formas personales y directas, sin la intermediación de un dispositivo móvil, así como poner a un lado cualquier dispositivo al estar frente a otra persona.

¡Mucha felicidad, desarrollo y progreso para 2017!