Los objetivos son similares: reducir la brecha digital, facilitar el aprendizaje, extender la cobertura para incluir las zonas rurales y las menos atendidas, preparar a los niños y jóvenes para seguir aprendiendo, desarrollar las competencias necesarias para el siglo XXI, y más. Varias iniciativas, proyectos e investigaciones buscan lograr metas en algunas de estas áreas, haciendo uso de las posibilidades, avances y configuraciones tecnológicas en el campo de las telecomunicaciones, y aprovechando las reducciones de tamaño y precio de los dispositivos electrónicos.

Muchas personas trabajan constantemente por esos ideales, en distintos lugares del mundo, y desde sus propias disciplinas. Hay buenas experiencias, lecciones aprendidas y aspectos a mejorar, y afortunadamente existen varias iniciativas que se pueden y deben evaluar en países como el nuestro, para contribuir a la mejora de los niveles de educación y desarrollo humano, además de proveer las competencias necesarias y una mejor posibilidad de inserción en el mundo productivo.

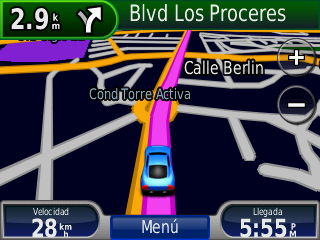

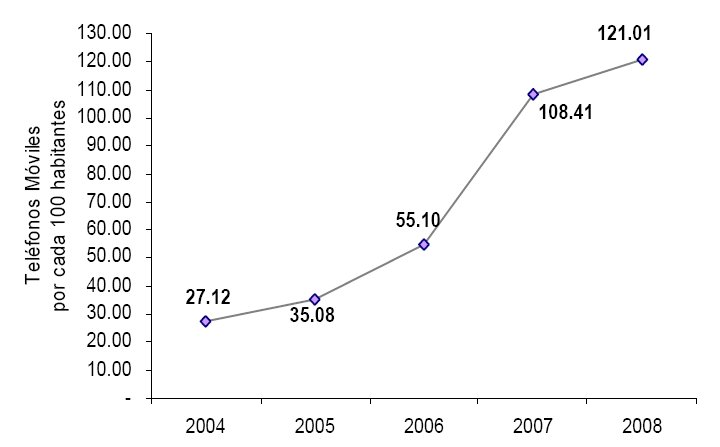

En este sentido, y con sólo observar a nuestro alrededor, es evidente que la proliferación de los dispositivos de comunicación móviles ha ido cada vez en aumento, tanto en El Salvador como en el resto del mundo. Los teléfonos celulares, como parte de esta industria, tienen suficientes ventajas para los ciudadanos como para adquirir hasta más de un aparato (1.21 por persona durante 2008, para ser más precisos), como lo reflejan las gráficas más recientes publicadas por la SIGET.

OLPC y ClassMate

Considerando este “milagro móvil” contemporáneo, las pequeñas computadoras desarrolladas con los nombres de OLPC XO (One Laptop Per Child modelo XO) y ClassMate representan dos de los dispositivos móviles más conocidos en los años recientes que buscan apoyar el proceso educativo con tecnología informática y de telecomunicaciones, sobre todo para niños, niñas y jóvenes en lugares remotos.

Además de sus diseños y características particulares, la idea ha sido poder fabricarlas a precios relativamente bajos, de forma que un gobierno, una ONG o una empresa privada, por ejemplo, puedan financiar su difusión en las regiones a su cargo, aprovechando las economías de escala al producirlas.

Las computadoras denominadas OLPC surgieron de las ideas y planteamientos de Nicholas Negroponte, del Media Lab del Instituto Tecnológico de Massachussets (MIT). Como lo establece su sitio web, “Nicholas Negroponte fundó la OLPC partiendo de un núcleo de veteranos del Media Lab, que creció rápidamente incorporando al grupo personas dedicadas y excepcionalmente talentosas provenientes de la enseñanza, la industria, las artes, los negocios y la comunidad open-source”.

Por su parte, la ClassMate PC es una pequeña computadora, cuyo procesador fue diseñado por Intel, para dar una respuesta al potencial mercado que la OLPC habría comenzado a generar en 2006. Surgió a partir del programa “World Ahead” de Intel, cuya motivación era realizar productos baratos y eficientes destinados a estudiantes.

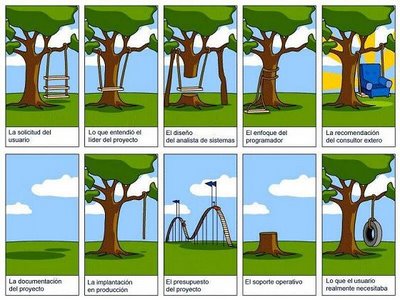

Es posible realizar una comparación de ambas (y otras) propuestas, tanto desde la perspectiva estrictamente de prestaciones tecnológicas, así como de la oferta en software, principios y prácticas pedagógicas asociadas a cada dispositivo, y seguramente encontraremos ventajas y aspectos por mejorar en cada caso.

TeacherMate: la propuesta de Stanford

Dentro de esta misma tendencia, recientemente hemos conocido en El Salvador otra posibilidad tecnológica para apoyar los objetivos de los programas educativos. Se trata de un dispositivo móvil de un costo cercano a los $50, llamado TeacherMate, y que fuera presentado en el país por el doctor Paul Kim, de la Universidad de Stanford, en un evento organizado por quien será su aliado en El Salvador, la Universidad Tecnológica.

Por supuesto, al igual que con sus proyectos pares, mencionados antes, el dispositivo no es más que un elemento dentro de una estrategia específica para intentar lograr los objetivos de acercar las posibilidades de aprendizaje a niños y niñas de menos posibilidades económicas. Para el dr. Kim, el objetivo de este esfuerzo es “promover y desarrollar aplicaciones y juegos móviles que faculten a 6,7 millones de personas en la tierra. En esta misión, nos centramos en la alfabetización temprana, la matemática, la salud, los derechos humanos, la estrategia de potenciación por el auto-aprendizaje, el desarrollo de contenidos y la difusión de las mejores prácticas”.

El planteamiento pedagógico que acompaña al dispositivo TeacherMate es el PocketSchool, la “Escuela de Bolsillo”, que habla de un currículo elástico (adaptable al ritmo de aprendizaje de los niños), y de un aprendizaje basado en juegos.

El TeacherMate utiliza una versión del sistema operativo de código abierto Linux, y se programa con Open Flash, también de código abierto, lo que reduce los costos de llevarlo a la operación en escuelas reales, y permite la flexibilidad necesaria para adaptarlo a distintos ambientes (se está utilizando en países tan diversos como México, Ruanda, Estados Unidos, India).

¿Y en El Salvador?

El Ministerio de Educación, por medio del Viceministerio de Ciencia y Tecnología y la Gerencia de Tecnologías Educativas, está desarrollando una experiencia piloto con las computadoras OLPC XO, habiendo seleccionado para ello algunas escuelas públicas rurales en la localidad de Nombre de Jesús, en el departamento de Chalatenango, induciendo y preparando a los docentes de estas escuelas para que sepan relacionarse con estos dispositivos, y puedan trabajar con sus estudiantes, que harán uso de las mismas computadoras, aprovechándolas en el proceso de enseñanza aprendizaje.

Al mismo tiempo, desarrollarán otra experiencia piloto con las TeacherMate, contando con el acompañamiento del equipo del profesor Kim, y el trabajo conjunto con la Universidad Tecnológica. Esta experiencia será conducida en una escuela de Nueva Concepción, también en Chalatenango. En este caso, se busca que estudiantes de la universidad desarrollen los programas adecuados para nuestro país, siguiendo la filosofía planteada por sus creadores, pero cuidando su adaptación a nuestro medio.

A partir de estas y otras experiencias en el campo, con escuelas, docentes y alumnos reales, salvadoreños, en zonas menos favorecidas, habrá oportunidad de evaluar los resultados, rectificar lo que no vaya bien, adaptar la programación, y seguramente será necesario resolver una serie de problemas, inconvenientes y situaciones inesperadas. Lo importante es hacerlo.

Conducir estas experiencias de una forma profesional, responsable y sistemática contribuirá sin duda a establecer hasta dónde las tecnologías de información y comunicaciones, y sobre todo las móviles, realmente pueden hacer una diferencia en países como el nuestro.