Las carreteras por las que circula un turista y su familia cuando viaja de un país a otro, o cuando visita los sitios arqueológicos dentro de un territorio, son las mismas que utilizan los furgones que llevan ayuda humanitaria a pueblos y ciudades que lo necesitan, así como los camiones que trasladan drogas, armas o mercancía de contrabando entre las fronteras de naciones vecinas.

En el caso de la red terrestre de carreteras, en algunos países y regiones, es posible optar por tomar la vía libre y llegar un tiempo después al destino, o bien seguir la carretera con peaje, en la cual tras pagar una cuota es posible completar el viaje en menor tiempo y quizá en una autopista de mayor calidad. Cualquiera puede tomar la opción de su preferencia. ¿Qué pasaría si solamente se permitiera a los vehículos de modelos superiores al año 2000 que usaran la carretera con peaje y mejores condiciones, y todos los demás automóviles debieran usar la vía alterna, más lenta y menos cómoda?

La neutralidad de la red, aplicada sobre todo a Internet, se refiere a que los contenidos que circulan en la red deben hacerlo en forma irrestricta e indiscriminada, sin considerar las marcas o modelos de los equipos, sin preferir a uno u otro proveedor de contenido, sin favorecer uno u otro servicio provisto en Internet; manteniendo igualdad en la calidad del servicio, la prioridad en el acceso y de la velocidad de carga y descarga independientemente de lo que cada usuario haga en su dispositivo terminal.

Unos a favor y otros no

Internet nació sin mayores restricciones. En los albores de esta gran red las únicas limitantes eran las dadas por la tecnología y la cobertura. A medida se crearon nuevos dispositivos y mejores protocolos de telecomunicaciones, se inventaron nuevas formas tecnológicas como el acceso inalámbrico y la transmisión de datos por medio de las redes celulares, estas limitaciones han ido cediendo paulatinamente, y cada vez son más las personas en el mundo que acceden a las posibilidades de comunicación, publicación y difusión de Internet.

Los promotores de la neutralidad de la red sostienen que ése es el estado que debe prevalecer en la forma de administrar Internet en todo el mundo. Sus argumentos pasan por el respeto de la libertad que cada usuario de la red debe tener para escoger el servicio o el contenido que desea usar, revisar o publicar en Internet; los proveedores de conectividad, los gobiernos o las empresas que proveen servicios o contenidos no deben hacer nada que favorezca a uno sobre otro sitio web en la red, por ejemplo. Esto incluye la oposición a hacer uso de cualquier tipo de censura externamente impuesta.

Hay otros que matizan esta libertad del usuario, y argumentan que, en ciertos casos, es posible que sea necesaria ciertas restricciones en el acceso a la información, tales como atendiendo a la edad de los cibernavegantes, o según el tipo de contenido que se expone, cuando está claro que su libre acceso puede dar pauta a un peligro real, como la fabricación de bombas caseras o las recetas para formular poderosos venenos, por ejemplo.

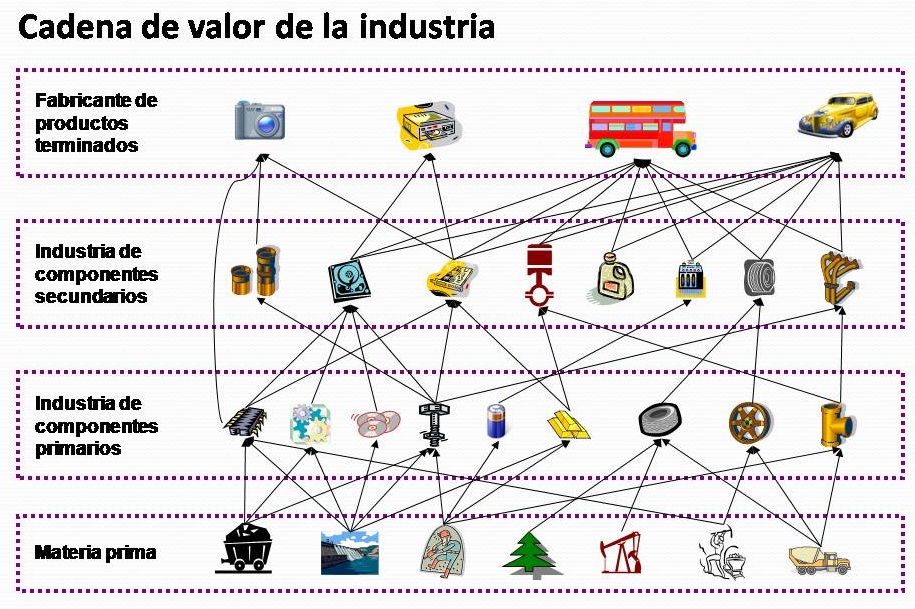

También hay otros que creen que desarrollar algún tipo de discriminación en lo que circula a través de la red también puede contribuir a la innovación y la creación de nuevos servicios, o a mejorar la calidad de los mismos. Para ellos, establecer diferencias en lo que los usuarios pueden acceder es un aliciente para que las empresas y los creadores sepan que pueden generar ganancias con sus innovaciones.

Leyes acerca de neutralidad

En algunos países se han establecido leyes y normas que favorecen la neutralidad de la red, buscando que no se creen ventajas de acceso para un usuario sobre otro en base a la cantidad de dinero que le pagan a su proveedor, más allá del ancho de banda acordado.

En Chile, por ejemplo, la ley vigente establece normativas en los siguientes aspectos:

- Información detallada: Características comerciales de los planes (velocidad de subida y bajada, límites de descargas garantías del servicio), Tasa de Agregación o Sobreventa y Tiempo de Reposición del Servicio.

- Libertad de acceso: La ley de Neutralidad garantiza el derecho de acceder libremente a cualquier tipo de contenido o servicio legal en Internet, sin que el proveedor pueda negar dicho acceso o interferir en tus decisiones de navegación o consumo: descargas de archivos (P2P), proveedores de video en línea, juegos en línea, telefonía IP, tethering desde el celular, etc., o cualquier contenido o servicio que se pueda encontrar en la red.

- Indicadores de calidad: La empresa que provee Internet deberá realizar, trimestralmente, mediciones de los indicadores técnicos de calidad de sus servicios, en base a protocolos técnicos aprobados por la Subsecretaría de Telecomunicaciones.

Debates, protestas y SOPA

Vinculando la neutralidad de la red con otros temas sujetos a largos debates, como las leyes de protección de derechos de autor, los temas se vuelven más delicados.

En particular, leyes como la propuesta en Estados Unidos a través de la SOPA (Stop Online Privacy Act) que busca frenar la piratería de música, libros, películas y otros materiales registrados por leyes que protegen la autoría y propiedad intelectual, también dará las herramientas legales para que, en casos comprobados (que serán potencialmente muchos), se puedan clausurar los servicios que presta un proveedor de contenidos, como Google, Yahoo!, Facebook, Twitter, y los proveedores de conectividad.

A raíz de esta ley propuesta que se espera pase a aprobación el 24 de enero, los principales proveedores de contenido de Estados Unidos han acordado, como medida de protesta, que el día 23 de enero de 2012 llevarán a cabo un “apagón general” de sus servicios, por lo que ellos consideran un atentado a la libertad de realización de sus actividades a través de una potencial censura que les causaría millones de dólares en ausencia de ganancias.

La mayoría de éstas son motivaciones financieras y económicas. Sin embargo, el remedio podría llegar a ser peor que la enfermedad, al reducir o anular la neutralidad de la red. ¿Cuál debería ser el tratamiento justo y correcto?